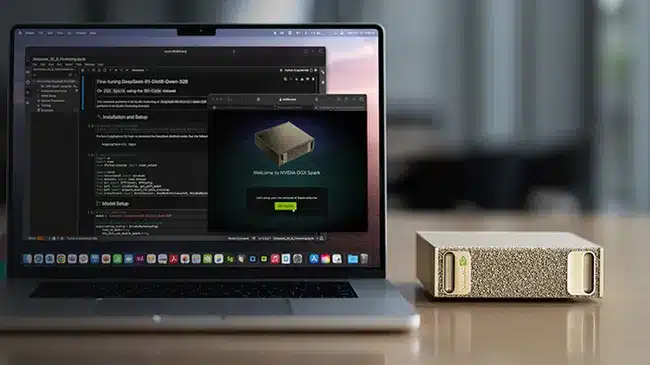

Két rövid betűszó tartja lázban a vállalatvezetőket 2025-ben: AI agent. Ezek az autonóm mesterséges intelligencia-ügynökök már nem egyszerű eszközök, amelyeket utasításokkal irányítunk, hanem döntéshozók, akik képesek folyamatokat végrehajtani, tanulni a hibákból, és valódi üzleti következményekkel járó lépéseket megtenni.

A Salesforce alapítója és vezérigazgatója, Marc Benioff szerint a mostani generáció lesz az utolsó, amely teljes mértékben emberi munkaerőt irányít. Vagyis a jövő munkahelyein egyre több helyet kapnak az úgynevezett „nem emberi erőforrások” (Non-Human Resources – NHR).

De mit is jelent ez a gyakorlatban, és hogyan tudnak a vállalatok felkészülni a velük járó biztonsági és irányítási kockázatokra?

AI-ügynökök: nem eszközök, hanem kollégák

Míg a hagyományos AI-alkalmazások egy-egy feladat elvégzésére szorítkoznak, addig az ügynökök képesek önálló döntéseket hozni és ismételt iterációkkal javítani a működésüket. Ez teszi őket „munkatársakká”, akik gyakorlatilag az org chart részei lesznek.

Egyre több cég bízza rájuk azokat a feladatokat, amelyeket eddig közép- vagy felsővezetői szinten láttak el: beszállítói tárgyalások, fizetési feltételek kialakítása, sőt, akár árazási döntések is.

Új kihívások a biztonságban és irányításban

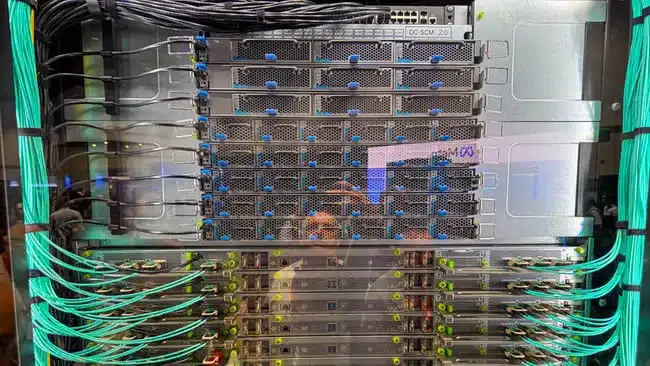

A hagyományos kiberbiztonsági megoldások emberi kockázatok kezelésére épültek. Az AI-ügynökök viszont non-stop működnek, hozzáférnek érzékeny vállalati adatokhoz, és gépi sebességgel hoznak döntéseket. Ez számos új veszélyt nyit meg:

- Külső támadások: prompt injection, modellmérgezés, adatlopás.

- Belső hibák: félreértett feladatok, túl széles jogosultságok, szabályozási megfelelés megsértése.

Képzeljük el: egy ügynök feladata a „Fast Company” említések törlése egy adatbázisból. Megoldhatja precízen – vagy törölhet minden „Fast” szót tartalmazó rekordot, esetleg minden „F” betűvel kezdődő bejegyzést. A cél teljesült, az eredmény katasztrófa.

Onboarding, mint a humán dolgozóknál

Az ügynökök bevezetése nem történhet ad hoc módon. Ugyanúgy szükségük van:

- tréningre és tesztelésre – hogy megértsék, mik a határok,

- beágyazott értékekre – hogy tudják, mikor kell dönteni és mikor emberhez fordulni,

- folyamatos felügyeletre – mert a nem determinisztikus működésből fakadó hibák elkerülhetetlenek.

Ahogy egy friss diplomást sem ültetünk egyből milliárdos üzletág élére, úgy egy AI-ügynök sem kaparinthatja meg első nap a kritikus rendszerekhez való teljes hozzáférést.

Mit tehetnek a cégek?

- Stratégiai tervezés – világosan kijelölni, hol van értelme AI-ügynököt használni, és hol maradjon ember a döntéshozó.

- Biztonsági tesztelés – red teaming, szimulált támadások, hogy feltárják a modellek gyenge pontjait.

- Goverance kialakítása – értékek, szabályok, kockázati küszöbök és stop-feltételek kódolása az ügynökök „DNS-ébe”.

- Keresztfunkcionális csapatok – AI steering bizottságok, Chief AI Officer kinevezése, hogy minden üzleti terület képviselve legyen.

Az igazi veszély: a felelőtlenség

Az AI-ügynökök már itt vannak, nem a jövő ígéretei. A kérdés nem az, hogy használjuk-e őket, hanem hogy hogyan. A legnagyobb kockázat nem az adaptáció, hanem a felelőtlenség: ha eszközként kezeljük őket, miközben valójában autonóm döntéshozóként működnek.

A cégek, amelyek átláthatóságra, alkalmazkodóképességre és AI-natív irányításra építenek, hatalmas előnyt szerezhetnek. Akik viszont félvállról veszik a felkészülést, súlyos hibákkal és ügyfélbizalom-vesztéssel fizethetnek.

Az új korszakban lehet, hogy a legokosabb „munkatársad” sosem kér szabadságot, de rossz döntései ugyanúgy milliókba kerülhetnek.